这事我们要慢慢聊,PUE和IUE都是什么?

今天,我们聊数据中心,但主要不是聊PUE,来聊聊IUE!

话说,维缔技术(Vertiv)在日前创新性推出了基于POD(性能优化数据中心)架构的供电最佳颗粒度和制冷最佳颗粒度模型。

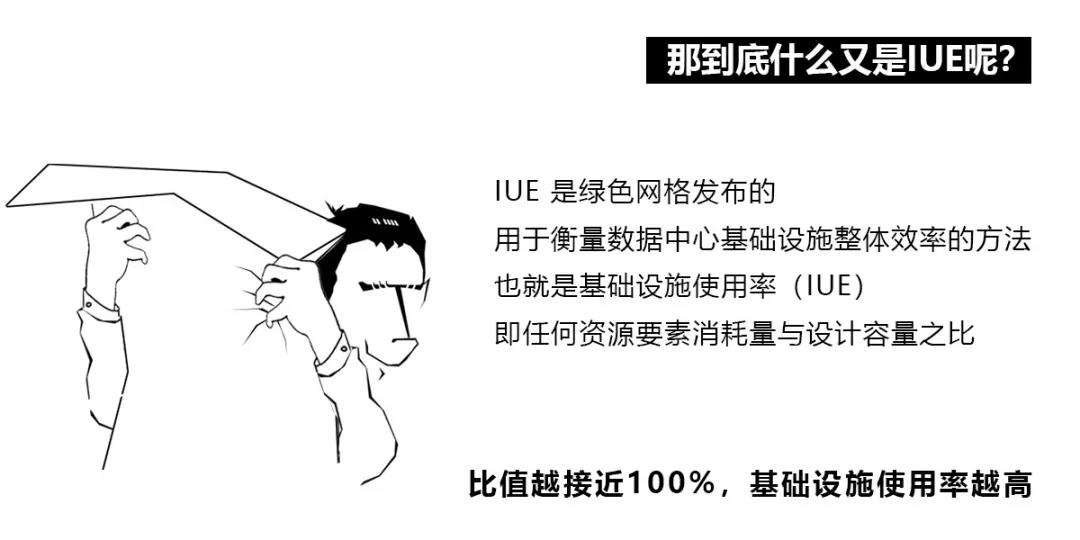

开篇提到的PUE,它是绿色网格发布的一个用于衡量数据中心能源使用效率的方法(或公式)。PUE指的是数据中心总耗电与真正用在IT上的耗电的比值,PUE越小(趋近于1)意味着能效越高。

相对于PUE只衡量数据中心内的供电效率,显然影响IUE的因素多得多,数据中心内基础设施不仅包括IT和供电,实际上还有散热以及冷却流量、机架U位和电量分配(配电开关分配)等等。

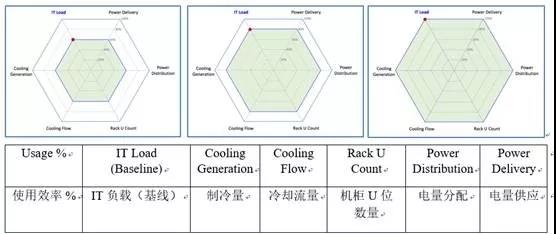

根据数据中心内的必备要素,IUE设计了五个资源要素,分别为:电量供应(Power Delivery)、电量分配(Power Distribution)、制冷量(Cooling Generation)、冷却流量(Cooling Flow)以及机架U位数量(Rack U Count)等。

完美使用模式---资源使用率与IT负载率匹配(来源:绿色网格)。当IT负载率(与设计量的比值)达到相应的级别,其他如供电、冷量等也占用相同的比值。最完美的使用模式是当IT负载率达到100%时,电量供应和制冷量资源使用率趋近100%。

相比于PUE只提供了一个比值或者说一个衡量标准,IUE要复杂很多,提供了一套方法论,指导数据中心用户可以从上述五个方面去提高数据中心基础设施使用率,从而建设高效数据中心,最终降低TCO。

多角度构建云计算数据中心最佳颗粒度

尽管绿色网格近期才发布IUE的衡量标准,但实际上很多公司都在这方面已经进行了大量的探索,尤其是因成本驱动的互联网公司、公有云服务商和云托管运营商,如何最大化数据中心基础设施使用率,以让投资收益最大化是他们永恒的追求,IUE衡量标准发布正是这些探索的总结。

维谛技术(Vertiv)大中华区数据中心解决方案部高级总监 吴健

在维谛技术(Vertiv)大中华区数据中心解决方案部高级总监 吴健(绿色网格中国副主席)看来,为保持IT负载正常运行,机架U位数量、电量分配以及冷却流量这些指标在所有数据中心基本难分伯仲,在云计算数据中心的最关键需要提高的指标就包含云计算数据中心的IT使用率、电量供应和制冷量资源的使用率。

第一,IT机房最佳颗粒度。

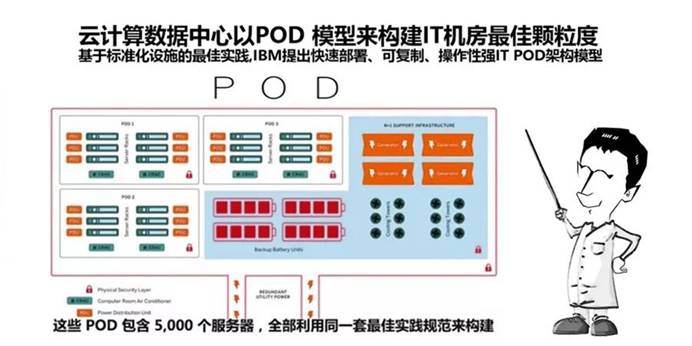

最早在这方面进行探索并公布成果的是IBM公司,基于标准化设施的最佳实践,提出可快速部署、可复制、操作性强的IT POD架构模型,所谓POD就是Performance Optimize Datacenter,即性能优化的数据中心。

上图是IBM提出的POD架构模型示意图,这一模型已经被广泛应用于大规模数据中心当中,包括亚马逊、微软、Facebook、Equinix以及Digital Realty,前三者是最大公有云供应商或互联网公司,后两者则是全球最大的两家数据中心托管运营商。

每个POD内IT部分包含5000台服务器,分属到200个机架。如果以每台服务器400W(瓦特)功率计算的话,每个机柜需要10KW(千瓦)的供电,即每个POD的IT负载容量是2MW(兆瓦)。每个机柜10KW的供电能力在数据中心领域已经达到极高水平了。

未来数据中心总是朝着更大型化、更集约化方向发展,数据中心建设由规模产生效率,规模越大,效率越高, TCO(总拥有成本)也越低。

那么每个POD内200个机架共5000台服务器,这一数字模型是怎么确定的呢?

为什么不是每个POD摆放更多的300个机架或者400个机架?

七氟丙烷的最大灭火体积是3600立方米,如果以数据中心楼层层高4.5米计算的话,那么可摆放机架的面积为800平方米,考虑到运维所需要的通道等因素,每个机架以占地IT机房4平方米计算,即在七氟丙烷灭火区域内可部署200个机架。

也就是说,单个POD部署5000台服务器、200个机架以及2MW的IT负荷,是当前性能优化的数据中心设计。

这一POD模型一经提出之后,获得了大规模数据中心拥有者的广泛认可,不仅获得国外如AWS、微软、Facebook、Equinix以及Digital Realty等青睐,同时也适用于国内的数据中心建设。

第二,供电的最佳颗粒度。

上述文中只确定了POD模型中的服务器机架数量,以及所需要的功率。同样道理,数据中心供电也是朝着更大UPS系统功率方向发展;而如何选择云计算数据中心供电最佳颗粒度则又由三个因素决定:变压器容量、UPS单模组容量以及并机系统的可靠性(至少高于单机)。

首先就是变压器的容量,通常变压器有1250KVA、1600KVA、2000KVA、2500KVA与3200KVA等容量选择,目前UPS单模组的容量考虑维护方便通常设计都小于800KVA,主要有600KVA、500KVA和400KVA等容量选择。

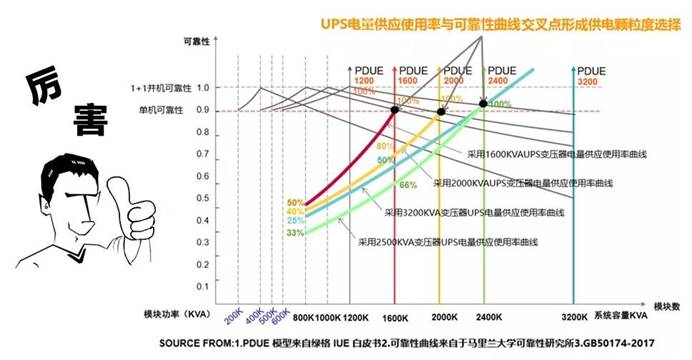

除了考虑UPS的容量之外,还要考虑UPS的可靠性,单模组UPS的容量是小于变压器的容量的,要接近或达到变压器的容量,则通过并联实现。但是UPS模组并联过多就会涉及到UPS并机环流问题,UPS并联的模组越多,意味着可靠性下降。从下图由马里兰大学CALCE研究中心提供的UPS并机可靠性曲线看到,当UPS并机模组数量超过4台,其并机系统的可靠性将比一台单机的可靠性还要低。

UPS电量供应使用率与UPS并机可靠性曲线,由马里兰大学可靠性研究所提供。

根据上图可以看出,在数据中心领域,根据UPS模组容量的不同(比如400KVA、500KVA、600KVA),在4台UPS并联后,UPS电量供应IUE曲线(最佳点是100%使用率)与可靠性曲线(要求并机的可靠性高于单机)的交叉点形成供电最佳颗粒度选择为1.6MVA、2MVA和2.4MVA。

第三,最佳的制冷颗粒度。

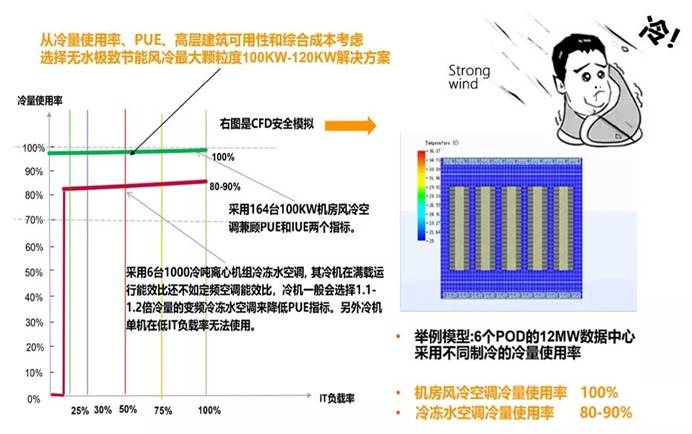

数据中心散热系统目前主流有“风冷”空调和“水冷”空调两种可供选择,

虽然目前大部分云计算数据中心比较青睐离心机或螺杆机的冷冻水“水冷”解决方案,但“水冷”空调散热系统的管道设计复杂,空调换热环节多,系统效率低,无法实现超低PUE的交付。且“水冷”空调系统的冷量设计较为巨大,以上千“冷吨”为单位,需要数百千瓦的电力供应,冷量使用率较低,维护成本很高,且不宜工作在低负载状态,进一步降低了散热系统的效率。

上图表示在相同POD数量下(以某个数据中心6个POD为例),“风冷”空调与“水冷”空调的冷量使用率对比。满足相同数量的服务器散热时,“风冷”空调的冷量使用率明显高过“水冷”空调。此外,IT低负载时,为了避免冷机“喘振”导致故障或停机,“水冷”空调散热系统通常不能使用。

在一个部署了6个POD的数据中心内,服务器总功耗为12MW,这意味需要12MW的冷量。

如果采用维谛技术(Vertiv)的Liebert®PEX4超高能效精密空调,单个POD需要22台(单台冷量100KW)以20+2的方式冗余制冷,同时考虑到电力机房与电池机房(UPS间)所需冷量,约共需要13.6MW的冷量(设计冷量)。而这个数据中心实际需要13.6MW冷量与设计冷量13.6MW之比即为冷量使用率(100%)。

而在相同条件如果采用“水冷”空调散热系统,采用6台1000冷吨离心机组冷冻水空调, 其冷机在满载运行能效比还不如定频空调能效比,冷机一般会选择1.1-1.2倍冷量的变频冷冻水空调来降低PUE指标,冷量使用率在80%-90%之间,另外冷机单机在低IT负载率无法使用。

为了提升冷量使用率和降低TCO,推荐适合高层建筑使用的无水极致节能风冷最大颗粒度120KW和100KW的解决方案。

维谛技术基于其在散热领域的深厚积淀,不止推出了PEX4超高能效精密空调,还有与PEX4搭配使用的Liebert®VCC集中式高效冷凝器,以及Liebert®PEH节能型湿膜加湿器。这些最新的产品不仅能够提高数据中心效率,还能节省占地面积,以及降低能耗。

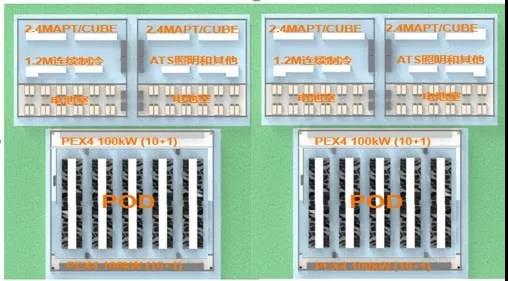

IT机架数、供电以及制冷都确定了,剩下的就是数据中心设计了。维谛技术(Vertiv)在这方面根据其在数据中心建设领域的丰富经验,以及其最佳组合的产品特点推出了面向云计算与互联网领域的Vertiv云计算最佳颗粒度解决方案,围绕POD而设计,将一个4层楼的数据中心2、3、4层布局如下:

维谛技术基于POD推出的云计算最佳颗粒度解决方案,具有快速部署上线、可复制以及操作性强等特点:

2、3、4层共3层楼共设置6个POD 共12MW 每层UPS 设置2.4MVA×2/POD,采用維谛高可靠高效率的 Cube or APT IT 机房设置风冷PEX4 100kW (20+2)/PODx6=132台 电力机房电池机房32台PEX4 100kW 预备800K电力,冗余400K共预备1.2M电力/POD用于连续制冷 每层设置400柜共占地4000-5000平米(含辅助区) 楼顶设置VCC外机,占楼顶面积30%

由于采用“风冷”空调散热系统替代了较为传统的“水冷”空调,这意味着不需要额外的冷站和蓄冷罐,而原本用于建设冷站的地下一层也可设计为IT机房,可在其内部署1个或2个POD及与之配套的供电与散热。

可以看出,维缔技术(Vertiv)打造的全方位供电和制冷的颗粒度方案,加上全球的供应链体系,可以帮助客户实现最优的TCO,目前在全球已经拥有了广泛的成功实践。

以全球第一大COLO运营商Equinix为例,每个数据中心采用维缔技术(Vertiv)N+1套2.4MVA UPS系统形成 2主1备RR系统或者3主1备RR系统的的最佳供电颗粒度解决方案。Equinix借助广泛部署在全球200多个International Business Exchange (IBX)数据中心,建立一个ECX Fabric云平台,在这个平台上9500多个客户可以快速地将自己的应用连接到全球Equinix部署的BIG EDGE云平台中,来降低延时和保证安全性。

另外一个例子是全球第二大COLO运营商DIGITAL REALTY,在其全球33个数据中心部署了2000台Vertiv Liebert®SDC400KW智慧双循环氟泵节能空调(适合海外2层建筑数据中心,不适合国内4层建筑数据中心);同时,根据可用性需求部署了创新的Vertiv Liebert®Trinergy™Cube系列MW级智能调控型UPS及Liebert®EXL系列大功率UPS。

吴健表示,把握数据中心IT、供电、制冷趋势,维缔技术(Vertiv)推出了云计算数据中心最佳颗粒度模型,其目的就是要让客户以最佳的成本,最佳的投资,最优的电量供应和冷量供应的使用率,最低的PUE,最少的占地面积,最可靠的系统可用性来构建高效数据中心,实现云计算与边缘计算的协同联动,推动云计算数据中心产业发展。

责任编辑:周星如